| Главная » Статьи » Ucoz |

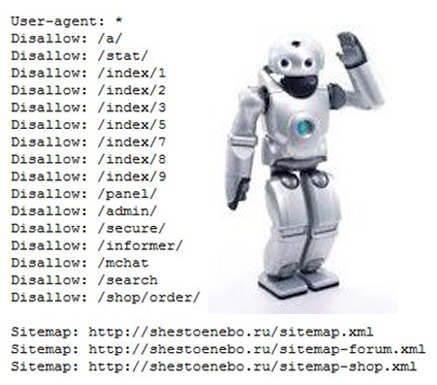

Сегодня я расскажу Вам о сайте robots.txt. Сразу отмечу, что ориентироваться я буду на Юкоз и расскажу только самые простейшие вещи, которые необходимо знать каждому, кто создает свой сайт на Юкосе. Итак, robots.txt нужен для того, чтобы четко ориентировать поисковых роботов на предмет того, какие страницы Вашего сайта ему индексировать, а какие не стоит. Так, например, совершенно ни к чему индексация различных служебных страниц, вроде страницы регистрации пользователя или страницы добавления материала. В Юкосе администрация уже обо всем позаботилась и создала файл robots.txt в том виде, в каком он в идеале должен быть у сайта, построенного на Юкосе. Поэтому администрация настоятельно рекомендует не заменять стандартный файл на свой. Более того, если Вы удалите случайно этот файл, система тут же пропишет его снова. Как я ужн говорила, файл robots.txt предназначен для поисковых роботов, поэтому в системе Юкос есть одно важное правило: первоначально при создании сайта в файле robots.txt прописано, что сайт полностью закрыт для индексации. Сделано это для того, чтобы дать Вам время наполнить сайт контентом и сделать необходимый дизайн, ведь если сайт проиндексируется раньше времени, он может быстро попасть в бан к поиковикам, а это никому не нужно. При посещаемости более 20 человек в день доступ к сайту открывается уже через 2 недели, у всех остальных он открывается через месяц. Поэтому в течение этого месяца не предпринимайте попытки прописать его в различных каталогах и поисковиках - это будет бесполезная, а иногда и вредная, трата времени. Также сайт могут открыть к индексации раньше положенного времени, если будет оплачена любая из платных услуг Юкоса, или Вы прикрепите свой доменное имя. Обращаю Ваше внимание, что запрет на индексацию не всегда снимается автоматически, поэтому, если Вы считаете, что Вы выполнили условия, о которых я писала выше, но видите, что запрет на индексацию не снят, пишите в техподдержку, и они снимут его. Во время карантина (запрета к индексации) Вы не сможете редактировать файл robots.txt, после Вы можете делать с ним все, что угодно. Вот пример стандартного robots.txt: User-agent: * Disallow: /a/ Disallow: /stat/ Disallow: /index/1 Disallow: /index/2 Disallow: /index/3 Disallow: /index/5 Disallow: /index/7 Disallow: /index/8 Disallow: /index/9 Disallow: /main/ Disallow: /admin/ Disallow: /secure/ Disallow: /informer/ Disallow: /mchat А вот пример файла robots.txt сайта, который еще запрещен к индексации: User-agent: UNetBot Disallow: /a/ Disallow: /stat/ Disallow: /index/1 Disallow: /index/2 Disallow: /index/3 Disallow: /index/5 Disallow: /index/7 Disallow: /index/8 Disallow: /index/9 Disallow: /panel/ Disallow: /admin/ Disallow: /secure/ Disallow: /informer/ Disallow: /mchat User-agent: * Disallow: / Посмотреть этот файл Вы можете по адресу http://адрес_вашего_сайта /robots.txt Теперь немного о командах: User-agent - показывает для каких роботов выполнять нижеследующие команды Disallow - запрещает к индексации все, что находится в указанном каталоге Allow - Наоборот разрешает к индексации указанный каталог или страницу. Приведу примеры из справки Яндекса: 1. User-agent: Yandex Disallow: / # блокирует доступ ко всему сайту User-agent: Yandex Disallow: /cgi-bin # блокирует доступ к страницам #начинающимся с '/cgi-bin' 2. User-agent: Yandex Allow: /cgi-bin Disallow: / # запрещает скачивать все, кроме страниц # начинающихся с '/cgi-bin' Думаю из этих примеров все понятно. Создавать файл robots.txt можно в любом текстовом редакторе, закачать на сайт можно через файловый менеджер. Если остались вопросы спрашивайте, постараюсь ответить. | |

| Просмотров: 1326 | Теги: | Рейтинг: 5.0/1 |

| Всего комментариев: 0 | |

| Шаблоны для Ucoz | |

Категории

| Ucoz [22] |

| Серфинг [1] |

| Накрутка [0] |

| Вебмастеру [2] |

| Черный список [1] |

| Раскрутка сайта [32] |

| Программы, софт [1] |

| Монетизация сайта [1] |

Чат

Игровые Шаблоны

Игровые Шаблоны КС шаблоны

КС шаблоны МайнКрафт

МайнКрафт Абстракция

Абстракция Софт

Софт